नियम लिखते समय, परफ़ॉर्मेंस से जुड़ी सबसे आम समस्या यह होती है कि डिपेंडेंसी से इकट्ठा किए गए डेटा को ट्रैवर्स या कॉपी किया जाता है. पूरे बिल्ड में एग्रीगेट किए जाने पर, इन कार्रवाइयों में O(N^2) समय या स्पेस लग सकता है. इससे बचने के लिए, यह समझना ज़रूरी है कि depsets का सही तरीके से इस्तेमाल कैसे किया जाए.

इसे सही तरीके से लागू करना मुश्किल हो सकता है. इसलिए, Bazel एक मेमोरी प्रोफ़ाइलर भी उपलब्ध कराता है. इससे आपको उन जगहों का पता लगाने में मदद मिलती है जहां आपने गलती की हो सकती है. चेतावनी: किसी खराब नियम को लिखने की लागत तब तक पता नहीं चलती, जब तक उसका बड़े पैमाने पर इस्तेमाल नहीं किया जाता.

डिपसेट का इस्तेमाल करना

नियम की डिपेंडेंसी से जानकारी इकट्ठा करते समय, आपको depsets का इस्तेमाल करना चाहिए. सिर्फ़ सामान्य सूचियों या डिक्ट का इस्तेमाल करके, मौजूदा नियम के हिसाब से जानकारी पब्लिश करें.

डेटासेट, जानकारी को नेस्ट किए गए ग्राफ़ के तौर पर दिखाता है. इससे जानकारी शेयर की जा सकती है.

इस ग्राफ़ पर ध्यान दें:

C -> B -> A

D ---^

हर नोड एक स्ट्रिंग पब्लिश करता है. डिपसेट के साथ डेटा ऐसा दिखता है:

a = depset(direct=['a'])

b = depset(direct=['b'], transitive=[a])

c = depset(direct=['c'], transitive=[b])

d = depset(direct=['d'], transitive=[b])

ध्यान दें कि हर आइटम का ज़िक्र सिर्फ़ एक बार किया गया है. सूचियों की मदद से, आपको यह जानकारी मिलेगी:

a = ['a']

b = ['b', 'a']

c = ['c', 'b', 'a']

d = ['d', 'b', 'a']

ध्यान दें कि इस मामले में 'a' का ज़िक्र चार बार किया गया है! बड़े ग्राफ़ में यह समस्या और भी बढ़ जाएगी.

यहां नियम लागू करने का एक उदाहरण दिया गया है, जिसमें ट्रांज़िटिव जानकारी पब्लिश करने के लिए, depsets का सही तरीके से इस्तेमाल किया गया है. ध्यान दें कि अगर आपको सूची का इस्तेमाल करके नियम से जुड़ी जानकारी पब्लिश करनी है, तो ऐसा किया जा सकता है. ऐसा इसलिए, क्योंकि यह O(N^2) नहीं है.

MyProvider = provider()

def _impl(ctx):

my_things = ctx.attr.things

all_things = depset(

direct=my_things,

transitive=[dep[MyProvider].all_things for dep in ctx.attr.deps]

)

...

return [MyProvider(

my_things=my_things, # OK, a flat list of rule-local things only

all_things=all_things, # OK, a depset containing dependencies

)]

ज़्यादा जानकारी के लिए, depset की खास जानकारी पेज देखें.

depset.to_list() को कॉल करने से बचें

to_list() का इस्तेमाल करके, किसी डिप्सेट को फ़्लैट लिस्ट में बदला जा सकता है. हालांकि, ऐसा करने पर आम तौर पर O(N^2) लागत आती है. अगर हो सके, तो डीबग करने के अलावा किसी और काम के लिए, depsets को फ़्लैट न करें.

आम तौर पर, यह गलतफ़हमी होती है कि अगर सिर्फ़ टॉप-लेवल के टारगेट, जैसे कि <xx>_binary नियम पर depsets को फ़्लैट किया जाता है, तो उन्हें बिना किसी शुल्क के फ़्लैट किया जा सकता है. ऐसा इसलिए, क्योंकि तब लागत, बिल्ड ग्राफ़ के हर लेवल पर नहीं जुड़ती है. हालांकि, ओवरलैप होने वाली डिपेंडेंसी वाले टारगेट का सेट बनाने पर, यह अब भी O(N^2) है. ऐसा तब होता है, जब टेस्ट बनाए जा रहे हों //foo/tests/... या जब किसी आईडीई प्रोजेक्ट को इंपोर्ट किया जा रहा हो.

कॉल की संख्या को depset तक कम करें

लूप के अंदर depset को कॉल करना अक्सर एक गलती होती है. इससे बहुत ज़्यादा नेस्टिंग वाले डिपसेट बन सकते हैं, जिनकी परफ़ॉर्मेंस खराब होती है. उदाहरण के लिए:

x = depset()

for i in inputs:

# Do not do that.

x = depset(transitive = [x, i.deps])

इस कोड को आसानी से बदला जा सकता है. सबसे पहले, ट्रांज़िटिव डिपसेट इकट्ठा करें और उन सभी को एक साथ मर्ज करें:

transitive = []

for i in inputs:

transitive.append(i.deps)

x = depset(transitive = transitive)

कभी-कभी, लिस्ट कंप्रीहेंशन का इस्तेमाल करके इसे कम किया जा सकता है:

x = depset(transitive = [i.deps for i in inputs])

कमांड लाइन के लिए ctx.actions.args() का इस्तेमाल करना

कमांड लाइन बनाते समय, आपको ctx.actions.args() का इस्तेमाल करना चाहिए. इससे, किसी भी depsets को एक्ज़ीक्यूशन फ़ेज़ में ले जाया जाता है.

यह तरीका, पहले तरीके से ज़्यादा तेज़ है. साथ ही, इससे आपके नियमों के लिए मेमोरी की खपत भी कम हो जाएगी. कभी-कभी यह 90% या इससे ज़्यादा भी हो सकती है.

यहां कुछ तरकीबें दी गई हैं:

depsets और सूचियों को सीधे तौर पर आर्ग्युमेंट के तौर पर पास करें. इन्हें खुद फ़्लैट करने की ज़रूरत नहीं है.

ctx.actions.args()आपके लिए उन्हें बड़ा कर देगा. अगर आपको डिसेट के कॉन्टेंट में कोई बदलाव करना है, तो ctx.actions.args#add देखें. इससे आपको पता चलेगा कि क्या कोई बदलाव किया जा सकता है.क्या आपने

File#pathको आर्ग्युमेंट के तौर पर पास किया है? ज़रूरत नहीं है. कोई भी फ़ाइल अपने-आप उसके पाथ में बदल जाती है. इसे एक्सपैंशन के समय के लिए रोक दिया जाता है.स्ट्रिंग को एक साथ जोड़कर बनाने से बचें. सबसे अच्छा स्ट्रिंग आर्ग्युमेंट एक कॉन्स्टेंट होता है, क्योंकि इसकी मेमोरी आपके नियम के सभी इंस्टेंस के बीच शेयर की जाएगी.

अगर कमांड लाइन के लिए आर्ग्युमेंट बहुत ज़्यादा हैं, तो

ctx.actions.args()ऑब्जेक्ट कोctx.actions.args#use_param_fileका इस्तेमाल करके, पैरामीटर फ़ाइल में लिखा जा सकता है. ऐसा कुछ शर्तों के साथ या बिना किसी शर्त के किया जा सकता है. जब कार्रवाई की जाती है, तो यह काम बैकग्राउंड में होता है. अगर आपको पैरामीटर फ़ाइल को साफ़ तौर पर कंट्रोल करना है, तोctx.actions.writeका इस्तेमाल करके इसे मैन्युअल तरीके से लिखें.

उदाहरण:

def _impl(ctx):

...

args = ctx.actions.args()

file = ctx.declare_file(...)

files = depset(...)

# Bad, constructs a full string "--foo=<file path>" for each rule instance

args.add("--foo=" + file.path)

# Good, shares "--foo" among all rule instances, and defers file.path to later

# It will however pass ["--foo", <file path>] to the action command line,

# instead of ["--foo=<file_path>"]

args.add("--foo", file)

# Use format if you prefer ["--foo=<file path>"] to ["--foo", <file path>]

args.add(format="--foo=%s", value=file)

# Bad, makes a giant string of a whole depset

args.add(" ".join(["-I%s" % file.short_path for file in files])

# Good, only stores a reference to the depset

args.add_all(files, format_each="-I%s", map_each=_to_short_path)

# Function passed to map_each above

def _to_short_path(f):

return f.short_path

ट्रांज़िटिव ऐक्शन इनपुट, depsets होने चाहिए

ctx.actions.run का इस्तेमाल करके कोई कार्रवाई बनाते समय, यह न भूलें कि inputs फ़ील्ड, depset स्वीकार करता है. इसका इस्तेमाल तब करें, जब इनपुट को ट्रांज़िटिव तरीके से डिपेंडेंसी से इकट्ठा किया जाता है.

inputs = depset(...)

ctx.actions.run(

inputs = inputs, # Do *not* turn inputs into a list

...

)

हैंगिंग

अगर Bazel काम नहीं कर रहा है, तो Ctrl-\ दबाएं या Bazel को SIGQUIT सिग्नल (kill -3 $(bazel info server_pid)) भेजें. इससे आपको $(bazel info output_base)/server/jvm.out फ़ाइल में थ्रेड डंप मिल जाएगा.

अगर Bazel काम नहीं कर रहा है, तो हो सकता है कि bazel info को न चलाया जा सके. इसलिए, output_base डायरेक्ट्री आम तौर पर आपकी वर्कस्पेस डायरेक्ट्री में मौजूद bazel-<workspace> सिंबल लिंक की पैरंट डायरेक्ट्री होती है.

परफ़ॉर्मेंस प्रोफ़ाइलिंग

Bazel, डिफ़ॉल्ट रूप से आउटपुट बेस में command.profile.gz को JSON प्रोफ़ाइल लिखता है. --profile फ़्लैग का इस्तेमाल करके, जगह को कॉन्फ़िगर किया जा सकता है. उदाहरण के लिए, --profile=/tmp/profile.gz. .gz से खत्म होने वाली जगह की जानकारी को GZIP की मदद से कंप्रेस किया जाता है.

नतीजे देखने के लिए, Chrome ब्राउज़र टैब में chrome://tracing खोलें. इसके बाद, "लोड करें" पर क्लिक करें और (कंप्रेस की गई) प्रोफ़ाइल फ़ाइल चुनें. ज़्यादा जानकारी वाले नतीजे देखने के लिए, नीचे बाएं कोने में मौजूद बॉक्स पर क्लिक करें.

नेविगेट करने के लिए, इन कीबोर्ड कंट्रोल का इस्तेमाल किया जा सकता है:

- "चुनें" मोड के लिए,

1दबाएं. इस मोड में, इवेंट की जानकारी देखने के लिए कुछ बॉक्स चुने जा सकते हैं. इसके लिए, नीचे बाएं कोने में जाएं. खास जानकारी और एग्रीगेट किए गए आंकड़े पाने के लिए, एक से ज़्यादा इवेंट चुनें. - "पैन" मोड के लिए,

2दबाएं. इसके बाद, व्यू को मूव करने के लिए माउस को खींचें और छोड़ें. बाईं/दाईं ओर जाने के लिए,a/dका भी इस्तेमाल किया जा सकता है. - "ज़ूम" मोड के लिए,

3दबाएं. इसके बाद, ज़ूम करने के लिए माउस को खींचें. ज़ूम इन/आउट करने के लिए,w/sका इस्तेमाल भी किया जा सकता है. - "टाइमिंग" मोड के लिए

4दबाएं. इस मोड में, दो इवेंट के बीच की दूरी को मेज़र किया जा सकता है. - सभी कंट्रोल के बारे में जानने के लिए,

?दबाएं.

प्रोफ़ाइल की जानकारी

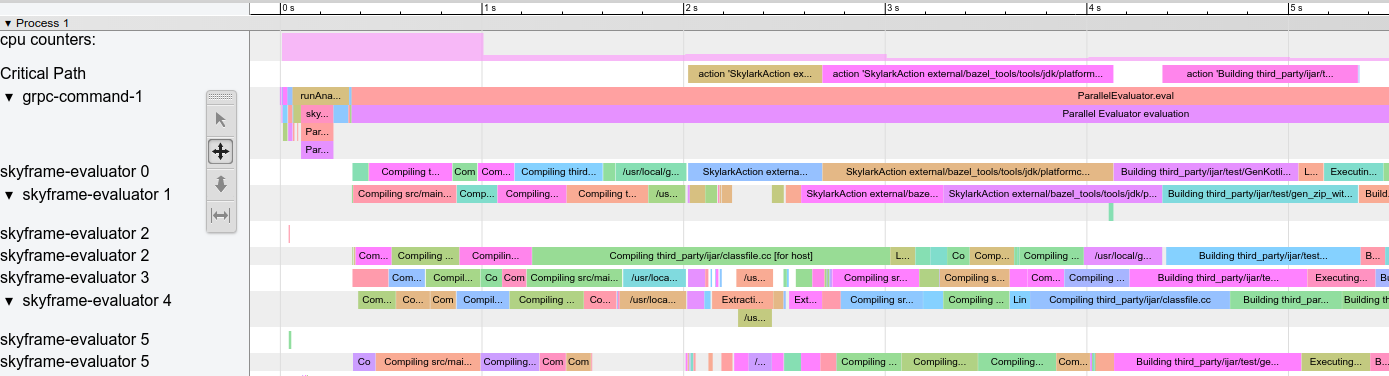

प्रोफ़ाइल का उदाहरण:

पहली इमेज. प्रोफ़ाइल का उदाहरण.

कुछ खास पंक्तियां होती हैं:

action counters: इससे पता चलता है कि एक साथ कितनी कार्रवाइयां चल रही हैं. असल वैल्यू देखने के लिए, इस पर क्लिक करें. यह वैल्यू, क्लीन बिल्ड में--jobsकी वैल्यू के बराबर होनी चाहिए.cpu counters: यह विकल्प, हर सेकंड के हिसाब से Bazel के इस्तेमाल किए गए सीपीयू की मात्रा दिखाता है. वैल्यू 1 का मतलब है कि एक कोर 100% व्यस्त है.Critical Path: यह क्रिटिकल पाथ पर की गई हर कार्रवाई के लिए एक ब्लॉक दिखाता है.grpc-command-1: Bazel की मुख्य थ्रेड. इससे यह समझने में मदद मिलती है कि Bazel क्या कर रहा है. उदाहरण के लिए, "Bazel लॉन्च करें", "evaluateTargetPatterns", और "runAnalysisPhase".Service Thread: इससे छोटे और बड़े गार्बेज कलेक्शन (जीसी) के रुकने की जानकारी मिलती है.

अन्य पंक्तियां, Bazel थ्रेड को दिखाती हैं. साथ ही, उस थ्रेड पर मौजूद सभी इवेंट दिखाती हैं.

परफ़ॉर्मेंस से जुड़ी सामान्य समस्याएं

परफ़ॉर्मेंस प्रोफ़ाइल का विश्लेषण करते समय, इन चीज़ों पर ध्यान दें:

- विश्लेषण के चरण (

runAnalysisPhase) में उम्मीद से ज़्यादा समय लगता है. ऐसा खास तौर पर, इंक्रीमेंटल बिल्ड पर होता है. यह नियम को सही तरीके से लागू न करने का संकेत हो सकता है. उदाहरण के लिए, ऐसा नियम जो depsets को फ़्लैट करता है. ज़्यादा टारगेट, मुश्किल मैक्रो या रिकर्सिव ग्लोब की वजह से, पैकेज लोड होने में ज़्यादा समय लग सकता है. - अलग-अलग कार्रवाइयों में होने वाली देरी, खास तौर पर अहम पाथ पर होने वाली कार्रवाइयों में. ऐसा हो सकता है कि बड़ी कार्रवाइयों को कई छोटी कार्रवाइयों में बांटा जा सके या उन्हें तेज़ी से पूरा करने के लिए, (ट्रांज़िटिव) डिपेंडेंसी के सेट को कम किया जा सके. यह भी देखें कि क्या किसी असामान्य रूप से ज़्यादा गैर-

PROCESS_TIME(जैसे किREMOTE_SETUPयाFETCH) का इस्तेमाल किया गया है. - बॉटलनैक, यानी कि कुछ थ्रेड व्यस्त हैं, जबकि बाकी सभी थ्रेड निष्क्रिय हैं या नतीजे का इंतज़ार कर रहे हैं (ऊपर दिए गए स्क्रीनशॉट में 15 से 30 सेकंड के बीच देखें). इसे ऑप्टिमाइज़ करने के लिए, नियम लागू करने या Bazel में बदलाव करने की ज़रूरत पड़ सकती है, ताकि ज़्यादा समानताएं लाई जा सकें. ऐसा तब भी हो सकता है, जब GC की मात्रा असामान्य हो.

प्रोफ़ाइल फ़ाइल फ़ॉर्मैट

टॉप-लेवल ऑब्जेक्ट में मेटाडेटा (otherData) और ट्रेसिंग का असल डेटा (traceEvents) होता है. मेटाडेटा में अतिरिक्त जानकारी होती है. उदाहरण के लिए, Bazel इनवोकेशन का आईडी और तारीख.

उदाहरण:

{

"otherData": {

"build_id": "101bff9a-7243-4c1a-8503-9dc6ae4c3b05",

"date": "Tue Jun 16 08:30:21 CEST 2020",

"profile_finish_ts": "1677666095162000",

"output_base": "/usr/local/google/_bazel_johndoe/573d4be77eaa72b91a3dfaa497bf8cd0"

},

"traceEvents": [

{"name":"thread_name","ph":"M","pid":1,"tid":0,"args":{"name":"Critical Path"}},

{"cat":"build phase marker","name":"Launch Bazel","ph":"X","ts":-1824000,"dur":1824000,"pid":1,"tid":60},

...

{"cat":"general information","name":"NoSpawnCacheModule.beforeCommand","ph":"X","ts":116461,"dur":419,"pid":1,"tid":60},

...

{"cat":"package creation","name":"src","ph":"X","ts":279844,"dur":15479,"pid":1,"tid":838},

...

{"name":"thread_name","ph":"M","pid":1,"tid":11,"args":{"name":"Service Thread"}},

{"cat":"gc notification","name":"minor GC","ph":"X","ts":334626,"dur":13000,"pid":1,"tid":11},

...

{"cat":"action processing","name":"Compiling third_party/grpc/src/core/lib/transport/status_conversion.cc","ph":"X","ts":12630845,"dur":136644,"pid":1,"tid":1546}

]

}

ट्रेस इवेंट में टाइमस्टैंप (ts) और अवधि (dur) को माइक्रोसेकंड में दिखाया जाता है. कैटगरी (cat) एट्रिब्यूट, ProfilerTask एट्रिब्यूट के लिए उपलब्ध ईनम वैल्यू में से एक है.

ध्यान दें कि अगर कुछ इवेंट बहुत छोटे हैं और एक-दूसरे के बहुत करीब हैं, तो उन्हें एक साथ मर्ज कर दिया जाता है. अगर आपको इवेंट मर्ज होने से रोकना है, तो --noslim_json_profile पास करें.

Chrome Trace Event Format Specification भी देखें.

analyze-profile

प्रोफ़ाइलिंग के इस तरीके में दो चरण होते हैं. पहले चरण में, आपको --profile फ़्लैग का इस्तेमाल करके, अपना बिल्ड/टेस्ट चलाना होगा. उदाहरण के लिए

$ bazel build --profile=/tmp/prof //path/to:target

जनरेट की गई फ़ाइल (इस मामले में /tmp/prof) एक बाइनरी फ़ाइल है. इसे analyze-profile कमांड की मदद से, पोस्टप्रोसेस और विश्लेषण किया जा सकता है:

$ bazel analyze-profile /tmp/prof

डिफ़ॉल्ट रूप से, यह कमांड दी गई प्रोफ़ाइल की डेटा फ़ाइल के लिए, खास जानकारी वाले विश्लेषण की जानकारी प्रिंट करती है. इसमें हर बिल्ड फ़ेज़ के लिए, अलग-अलग तरह के टास्क के लिए कुल आंकड़े शामिल होते हैं. साथ ही, इसमें क्रिटिकल पाथ का विश्लेषण भी शामिल होता है.

डिफ़ॉल्ट आउटपुट के पहले सेक्शन में, अलग-अलग बिल्ड फ़ेज़ में लगे समय की खास जानकारी दी गई है:

INFO: Profile created on Tue Jun 16 08:59:40 CEST 2020, build ID: 0589419c-738b-4676-a374-18f7bbc7ac23, output base: /home/johndoe/.cache/bazel/_bazel_johndoe/d8eb7a85967b22409442664d380222c0

=== PHASE SUMMARY INFORMATION ===

Total launch phase time 1.070 s 12.95%

Total init phase time 0.299 s 3.62%

Total loading phase time 0.878 s 10.64%

Total analysis phase time 1.319 s 15.98%

Total preparation phase time 0.047 s 0.57%

Total execution phase time 4.629 s 56.05%

Total finish phase time 0.014 s 0.18%

------------------------------------------------

Total run time 8.260 s 100.00%

Critical path (4.245 s):

Time Percentage Description

8.85 ms 0.21% _Ccompiler_Udeps for @local_config_cc// compiler_deps

3.839 s 90.44% action 'Compiling external/com_google_protobuf/src/google/protobuf/compiler/php/php_generator.cc [for host]'

270 ms 6.36% action 'Linking external/com_google_protobuf/protoc [for host]'

0.25 ms 0.01% runfiles for @com_google_protobuf// protoc

126 ms 2.97% action 'ProtoCompile external/com_google_protobuf/python/google/protobuf/compiler/plugin_pb2.py'

0.96 ms 0.02% runfiles for //tools/aquery_differ aquery_differ

मेमोरी प्रोफ़ाइलिंग

Bazel में मेमोरी प्रोफ़ाइलर पहले से मौजूद होता है. इससे, अपने नियम के मेमोरी इस्तेमाल की जांच की जा सकती है. अगर कोई समस्या है, तो हीप को डंप करके उस कोड की सटीक लाइन का पता लगाया जा सकता है जिसकी वजह से समस्या आ रही है.

मेमोरी ट्रैकिंग चालू करना

आपको इन दोनों स्टार्टअप फ़्लैग को Bazel के हर इनवोकेशन में पास करना होगा:

STARTUP_FLAGS=\

--host_jvm_args=-javaagent:$(BAZEL)/third_party/allocation_instrumenter/java-allocation-instrumenter-3.3.0.jar \

--host_jvm_args=-DRULE_MEMORY_TRACKER=1

इनसे सर्वर, मेमोरी ट्रैकिंग मोड में शुरू होता है. अगर आपने इनमें से किसी एक को भी Bazel इनवोकेशन के लिए इस्तेमाल नहीं किया, तो सर्वर रीस्टार्ट हो जाएगा और आपको फिर से शुरू करना होगा.

मेमोरी ट्रैकर का इस्तेमाल करना

उदाहरण के लिए, टारगेट foo को देखें और जानें कि यह क्या करता है. सिर्फ़ विश्लेषण करने के लिए, --nobuild फ़्लैग जोड़ें. इससे बिल्ड एक्ज़ीक्यूशन फ़ेज़ नहीं चलेगा.

$ bazel $(STARTUP_FLAGS) build --nobuild //foo:foo

इसके बाद, देखें कि पूरा Bazel इंस्टेंस कितनी मेमोरी इस्तेमाल करता है:

$ bazel $(STARTUP_FLAGS) info used-heap-size-after-gc

> 2594MB

bazel dump --rules का इस्तेमाल करके, इसे नियम क्लास के हिसाब से बांटें:

$ bazel $(STARTUP_FLAGS) dump --rules

>

RULE COUNT ACTIONS BYTES EACH

genrule 33,762 33,801 291,538,824 8,635

config_setting 25,374 0 24,897,336 981

filegroup 25,369 25,369 97,496,272 3,843

cc_library 5,372 73,235 182,214,456 33,919

proto_library 4,140 110,409 186,776,864 45,115

android_library 2,621 36,921 218,504,848 83,366

java_library 2,371 12,459 38,841,000 16,381

_gen_source 719 2,157 9,195,312 12,789

_check_proto_library_deps 719 668 1,835,288 2,552

... (more output)

bazel dump --skylark_memory का इस्तेमाल करके, pprof फ़ाइल जनरेट करें और देखें कि मेमोरी कहां जा रही है:

$ bazel $(STARTUP_FLAGS) dump --skylark_memory=$HOME/prof.gz

> Dumping Starlark heap to: /usr/local/google/home/$USER/prof.gz

ढेर की जांच करने के लिए, pprof टूल का इस्तेमाल करें. शुरुआत करने के लिए, pprof -flame $HOME/prof.gz का इस्तेमाल करके फ़्लेम ग्राफ़ पाना एक अच्छा विकल्प है.

pprof को https://github.com/google/pprof से डाउनलोड करें.

सबसे ज़्यादा कॉल पाने वाली साइटों का टेक्स्ट डंप पाएं. इसमें लाइनों के साथ एनोटेशन भी शामिल हैं:

$ pprof -text -lines $HOME/prof.gz

>

flat flat% sum% cum cum%

146.11MB 19.64% 19.64% 146.11MB 19.64% android_library <native>:-1

113.02MB 15.19% 34.83% 113.02MB 15.19% genrule <native>:-1

74.11MB 9.96% 44.80% 74.11MB 9.96% glob <native>:-1

55.98MB 7.53% 52.32% 55.98MB 7.53% filegroup <native>:-1

53.44MB 7.18% 59.51% 53.44MB 7.18% sh_test <native>:-1

26.55MB 3.57% 63.07% 26.55MB 3.57% _generate_foo_files /foo/tc/tc.bzl:491

26.01MB 3.50% 66.57% 26.01MB 3.50% _build_foo_impl /foo/build_test.bzl:78

22.01MB 2.96% 69.53% 22.01MB 2.96% _build_foo_impl /foo/build_test.bzl:73

... (more output)